Skalierung von Sicherheit und Netiquette auf Roblox

by Matt Kaufman, Chief Safety Officer

Tech

- Roblox wurde immer darauf ausgelegt, unsere jüngsten Nutzer zu schützen. Jetzt passen wir uns einem wachsenden Publikum älterer Nutzer an.

- Mit Text, Sprache, Bildern, 3D-Modellen und Code ist Roblox in der einzigartigen Position, um mit multimodalen KI-Lösungen erfolgreich zu sein.

- Wir verbessern die Sicherheit in der Branche, wo immer wir können, durch Open Source, Zusammenarbeit mit Partnern oder Unterstützung von Gesetzgebung.

Sicherheit und Anstand sind seit den Anfängen von Roblox vor fast 20 Jahren grundlegend. Bereits am ersten Tag haben wir uns verpflichtet, Sicherheitsfunktionen, Werkzeuge und Moderationsmöglichkeiten in das Design unserer Produkte zu integrieren. Bevor wir eine neue Funktion einführen, denken wir bereits darüber nach, wie wir die Community vor möglichen Gefahren schützen können. Dieser Prozess, bei dem Funktionen zur Erhaltung von Sicher von Anfang an entworfen werden, einschließlich früher Tests, um zu sehen, wie eine neue Funktion missbraucht werden könnte, hilft uns, Innovationen voranzutreiben. Wir evaluieren kontinuierlich die neuesten Forschungsergebnisse und verfügbare Technologien, um unsere Richtlinien, Werkzeuge und Systeme so genau und effizient wie möglich zu halten.

Wenn es um Sicherheit geht, hat Roblox eine einzigartige Position. Die meisten Plattformen begannen als Orte für Erwachsene und arbeiten nun nachträglich daran, Schutzmaßnahmen für Jugendliche und Kinder einzubauen. Aber unsere Plattform wurde von Anfang an als sicherer, schützender Raum für Kinder entwickelt, um zu kreieren und zu lernen, und wir passen uns jetzt einem schnell wachsenden Publikum an, das älter wird. Darüber hinaus ist das Volumen an Inhalten, die wir moderieren, exponentiell gewachsen, dank spannender neuer generativer KI-Funktionen und Werkzeuge, die es noch mehr Menschen ermöglichen, einfach auf Roblox zu erstellen und zu kommunizieren. Dies sind keine unerwarteten Herausforderungen – unsere Mission ist es, eine Milliarde Menschen mit Optimismus und Höflichkeit zu verbinden. Wir schauen immer in die Zukunft, um zu verstehen, welche neuen Sicherheitsrichtlinien und Werkzeuge wir benötigen, während wir wachsen und uns anpassen.

Neben einem mehrere Tausend starken Expertenteam, das sich der Sicherheit auf Roblox verschrieben hat, basieren viele unserer Sicherheitsfunktionen und Werkzeuge auf innovativen KI-Lösungen. Diese strategische Kombination aus erfahrenen Menschen und intelligenter Automatisierung ist unerlässlich, während wir daran arbeiten, das Volumen an Inhalten, die wir rund um die Uhr moderieren, zu skalieren. Wir glauben auch daran, Partnerschaften mit Organisationen zu pflegen, die sich auf Online-Sicherheit konzentrieren, und unterstützen gegebenenfalls Gesetzgebungen, von denen wir fest überzeugt sind, dass sie die Branche insgesamt verbessern werden.

Sicher skalieren durch führende KI

Die schiere Größe unserer Plattform erfordert KI-Systeme, die Branchenführer in Bezug auf Genauigkeit und Effizienz entsprechen oder übertreffen, um es uns zu ermöglichen, schnell zu reagieren, während die Community wächst, sich Richtlinien und Anforderungen ständig weiterentwickeln und neue Herausforderungen entstehen. Heutzutage kommunizieren und teilen mehr als 71 Millionen täglich aktive Nutzer in 190 Ländern Inhalte auf Roblox. Jeden Tag senden Menschen Milliarden von Chat-Nachrichten an ihre Freunde auf Roblox. Unser Creator Store hat Millionen von Artikeln im Angebot – und Creator fügen täglich neue Avatare und Artikel zum Marktplatz hinzu. Und dies wird sich immer mehr ausweiten, während wir weiter wachsen und neue Möglichkeiten schaffen, wie Menschen auf Roblox erstellen und kommunizieren können.

Während die Branche im Allgemeinen große Fortschritte im maschinellen Lernen (ML), mit großen Sprachmodellen (LLMs) und multimodaler KI macht, investieren wir stark in Möglichkeiten, diese neuen Lösungen zu nutzen, um Roblox noch sicherer zu machen. KI-Lösungen helfen uns bereits dabei, Textchats, immersive Sprachkommunikation, Bilder und 3D-Modelle und -Meshes zu moderieren. Wir verwenden jetzt viele dieser Technologien, um die Erstellung auf Roblox schneller und einfacher für unsere Community zu gestalten.

Innovation durch multimodale KI-Systeme

Unsere Plattform vereint naturgemäß Text, Sprache, Bilder, 3D-Modelle und Code. Multimodale KI, bei der Systeme gemeinsam auf mehrere Arten von Daten trainiert werden, um genauere und anspruchsvollere Ergebnisse als ein unimodales System zu erzielen, bietet Roblox eine einzigartige Chance. Multimodale Systeme sind in der Lage, problematische Kombinationen von Inhaltstypen (wie Bilder und Text) zu erkennen, auch wenn die einzelnen Elemente für sich genommen harmlos sind. Um sich vorzustellen, wie dies funktionieren könnte, nehmen wir an, ein Kind benutzt einen Avatar, der wie ein Schwein aussieht – völlig in Ordnung, oder? Nehmen wir jetzt an, jemand sendet eine Chat-Nachricht, in der steht „Das sieht genauso aus wie du!“ Diese Nachricht verstößt potenziell gegen unsere Richtlinien gegen Mobbing.

Ein Modell, das ausschließlich auf 3D-Modellen trainiert wurde, würde den Avatar genehmigen. Und ein Modell, das nur auf Text trainiert wurde, würde den Text genehmigen und den Kontext des Avatars ignorieren. Nur ein Modell, das über Text und 3D-Modelle trainiert wurde, wäre in der Lage, das Problem in diesem Beispiel schnell zu erkennen und zu kennzeichnen. Wir stehen noch in den Startlöchern in Bezug auf diese multimodalen Modelle, aber wir stellen uns eine Welt vor, in der unsere Systeme auf Meldungen von Verstößen reagieren, indem sie das gesamte Erlebnis überprüfen. Es könnte den Code, die Grafiken, die Avatare und die Kommunikation darin als Eingabe verarbeiten und feststellen, ob eine weitere Untersuchung oder Konsequenzen erforderlich sind.

Wir haben bereits bedeutende Fortschritte bei der Verwendung multimodaler Techniken gemacht, wie unser Modell, das Verstöße gegen Richtlinien in Sprachkommunikationen nahezu in Echtzeit erkennt. Wir beabsichtigen, Fortschritte wie diese zu teilen, wenn wir die Möglichkeit sehen, die Sicherheit und den Anstand nicht nur auf Roblox, sondern in der gesamten Branche zu erhöhen. In der Tat teilen wir heute unser erstes Open-Source-Modell, einen Sprach-Sicherheitsklassifizierer, mit der Branche.

Die Moderation von Inhalten im großen Umfang

Bei Roblox überprüfen wir die meisten Arten von Inhalten, um schwerwiegende Verstöße gegen Richtlinien zu erkennen, bevor sie auf der Plattform erscheinen. Dies ohne spürbare Verzögerungen für die Personen zu tun, die ihre Inhalte veröffentlichen, erfordert sowohl Geschwindigkeit als auch Genauigkeit. Bahnbrechende KI-Lösungen helfen uns, in Echtzeit bessere Entscheidungen zu treffen, um problematische Inhalte von Roblox fernzuhalten – und wenn doch etwas auf die Plattform gelangt, haben wir Systeme implementiert, um diese Inhalte zu identifizieren und zu entfernen, einschließlich unserer robusten Benutzer-Meldesysteme.

Wir haben gesehen, dass die Genauigkeit unserer automatisierten Moderationstools die der menschlichen Moderatoren bei wiederholbaren, einfachen Aufgaben übertrifft. Durch Automatisierung dieser einfacheren Fälle können wir unsere menschlichen Moderatoren dafür verfügbar machen, den Großteil ihrer Zeit mit dem zu verbringen, was sie am besten können – den komplexeren Aufgaben, die kritisches Denken und sorgsame Untersuchungen erfordern. Wenn es um Sicherheit geht, wissen wir jedoch, dass Automatisierung menschliche Überprüfung nicht vollständig ersetzen kann. Unsere menschlichen Moderatoren sind von unschätzbarem Wert, um uns bei der kontinuierlichen Überwachung und Prüfung unserer ML-Modelle auf Qualität und Konsistenz zu unterstützen und hochwertig annotierte Datensätze zu erstellen, um unsere Systeme auf dem neuesten Stand zu halten. Sie helfen dabei, neue Slangausdrücke und Abkürzungen in allen 16 von uns unterstützten Sprachen zu identifizieren und Fälle zu kennzeichnen, die häufig auftreten, damit das System darauf trainiert werden kann, sie zu erkennen.

Wir wissen, dass selbst hochwertige ML-Systeme Fehler machen können, deshalb haben wir menschliche Moderatoren in unserem Widerspruchsverfahren. Unsere Moderatoren helfen Personen, die Widerspruch eingelegt haben, und können darauf hinweisen, dass weiteres Training in den Fällen erforderlich ist, in denen Fehler gemacht wurden. Auf diese Weise wird unser System im Laufe der Zeit immer genauer und lernt sozusagen aus seinen Fehlern.Am wichtigsten ist, dass Menschen immer an allen wichtigen Ermittlungen beteiligt sind, die hochriskante Fälle wie Extremismus oder Kindesgefährdung betreffen. Für diese Fälle haben wir ein dediziertes internes Team, das aktiv Übeltäter identifiziert und entfernt und schwierige Fälle in unseren kritischsten Bereichen untersucht. Dieses Team arbeitet auch mit unserem Produktteam zusammen und teilt Erkenntnisse aus ihrer Arbeit, um die Sicherheit unserer Plattform und Produkte kontinuierlich zu verbessern.

Moderation von Kommunikation

Unser Textfilter wurde auf Roblox-spezifische Sprache, einschließlich Slang und Abkürzungen, trainiert. Die 2,5 Milliarden Chat-Nachrichten, die täglich auf Roblox verschickt werden, werden durch diesen Filter geleitet, der gut darin ist, gegen die Richtlinien verstoßende Sprache zu erkennen. Dieser Filter erkennt Verstöße in allen von uns unterstützten Sprachen, was besonders wichtig ist, seit wir Echtzeit-KI-Chat-Übersetzungen veröffentlicht haben.

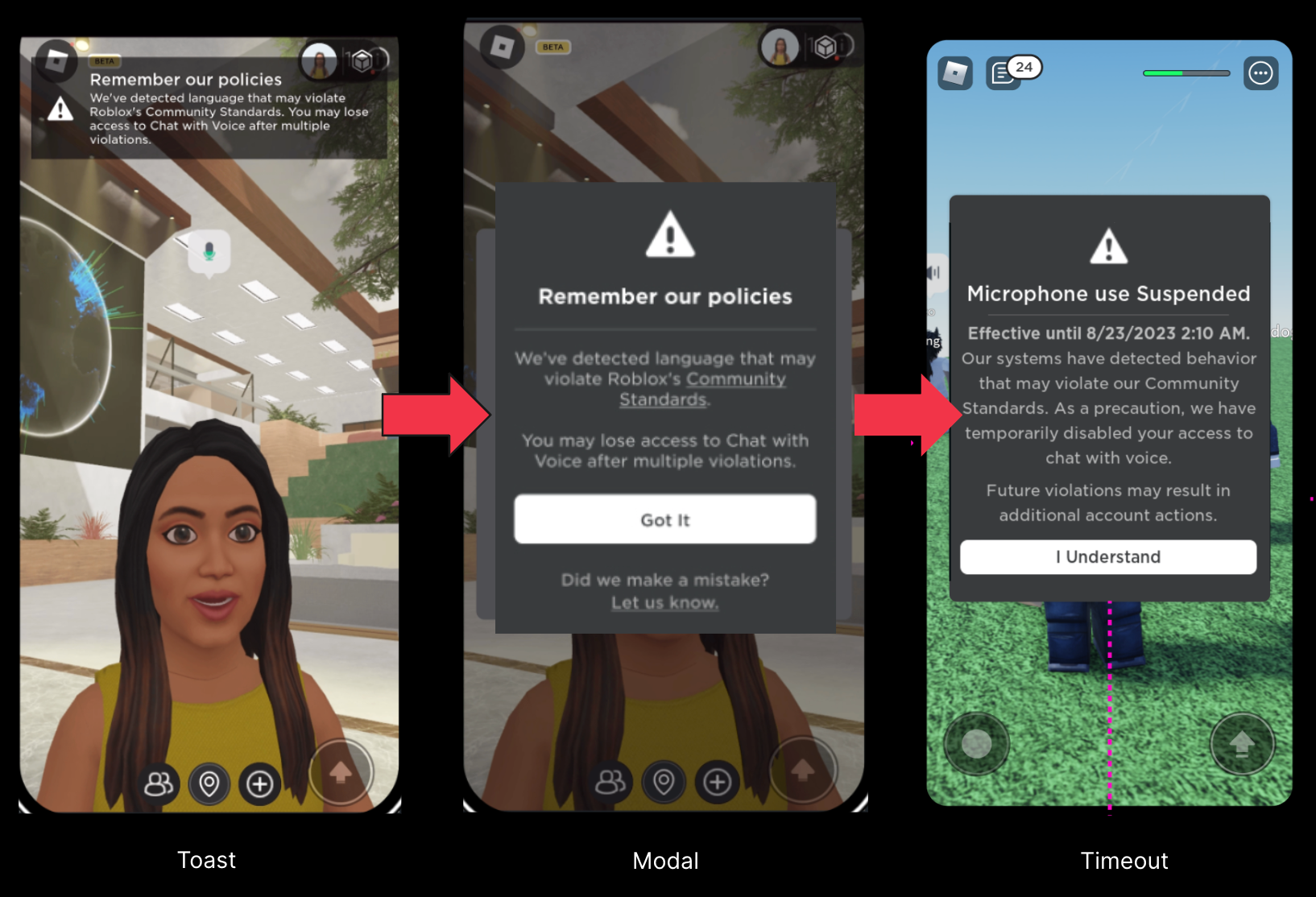

Wir haben zuvor geteilt, wie wir die Sprachkommunikation in Echtzeit über ein firmeninternes benutzerdefiniertes Spracherkennungssystem moderieren. Die Innovation hierbei liegt darin, dass wir direkt vom Live-Audio dazu übergehen können, dass das KI-System das Audio als regelwidrig oder nicht einstuft – und das in Sekundenschnelle. Als wir begannen, unser Sprachmoderationssystem zu testen, stellten wir fest, dass Menschen in vielen Fällen unabsichtlich gegen unsere Richtlinien verstoßen haben, weil sie nicht mit unseren Regeln vertraut waren. Wir haben unser Echtzeit-Sicherheitssystem entwickelt, um Menschen zu informieren, wenn ihre Sprache gegen eine unserer Richtlinien verstößt.

Diese Benachrichtigungen sind eine frühzeitige, milde Warnung, ähnlich wie die höfliche Bitte, auf seine Ausdrucksweise in einem öffentlichen Park zu achten, wenn sich dort junge Kinder befinden. Bei Tests haben sich diese Interventionen als erfolgreich erwiesen, um die Menschen daran zu erinnern, respektvoll zu sein und sie auf unsere Richtlinien zu verweisen, um mehr zu erfahren. Im Vergleich zu den Engagement-Daten sind die Ergebnisse unserer Tests ermutigend und deuten darauf hin, dass diese Tools wirksam sein können, um Übeltäter von der Plattform fernzuhalten und wirklich engagierte Nutzer dazu zu ermutigen, ihr Verhalten auf Roblox zu verbessern. Seit der Einführung von Echtzeitsicherheit für alle englischsprachigen Nutzer im Januar haben wir einen Rückgang von 53 Prozent der Verstoßesmeldungen pro täglich aktiven Nutzer festgestellt, wenn es um Sprachkommunikation ging.

Moderation von Kreationen

Für visuelle Elemente, einschließlich Avataren und Avatar-Accessoires, verwenden wir Computer Vision (CV). Eine Technik besteht darin, Fotos des Elements aus verschiedenen Blickwinkeln zu machen. Das System überprüft dann diese Fotos, um zu bestimmen, wie es weitergehen soll. Wenn nichts auffällig ist, wird das Element genehmigt. Wenn jedoch etwas klar gegen eine Richtlinie verstößt, wird das Element blockiert und wir teilen den Creatorn mit, was unserer Meinung nach falsch ist. Wenn sich das System nicht sicher ist, wird das Element an einen menschlichen Moderator geschickt, um es genauer zu untersuchen und die endgültige Entscheidung zu treffen.

Wir führen eine ähnliche Version dieses Prozesses für Avatare, Accessoires, Code und vollständige 3D-Modelle durch. Bei vollständigen Modellen gehen wir einen Schritt weiter und bewerten den gesamten Code und andere Elemente, die das Modell ausmachen. Wenn wir ein Auto bewerten, zerlegen wir es in seine Komponenten – das Lenkrad, die Sitze, die Reifen und den Code darunter -, um festzustellen, ob etwas problematisch sein könnte. Wenn ein Avatar wie ein Welpe aussieht, müssen wir beispielsweise überprüfen, ob die Ohren, die Nase und die Zunge problematisch sind.

Wir müssen auch in die andere Richtung bewerten können. Was ist, wenn die einzelnen Komponenten alle in Ordnung sind, aber ihr Gesamteffekt gegen unsere Richtlinien verstößt? Ein Schnurrbart, eine Khakijacke und ein rotes Armband sind z.B. für sich genommen nicht problematisch. Das Problem wird jedoch offensichtlich, wenn sie gemeinsam von deinem Avatar getragen werden, der zudem noch ein symbolischen Kreuz auf dem Armband hat und den Arm zu einem Nazi-Gruß erhebt.

Hier unterscheiden sich unsere hausinternen Modelle von den verfügbaren Standard-CV-Modellen. Diese sind in der Regel auf reale Gegenstände trainiert. Sie können ein Auto oder einen Hund erkennen, aber nicht die Bestandteile dieser Dinge. Unsere Modelle wurden so trainiert und optimiert, dass sie Objekte bis zu den kleinsten Bestandteilen bewerten können.

Zusammenarbeit mit Partnern

Wir nutzen alle uns zur Verfügung stehenden Tools, um alle Benutzer auf Roblox zu schützen – aber wir sind genauso bestrebt, das, was wir lernen, über Roblox hinaus zu teilen. Heute teilen wir unser erstes Open-Source-Modell, einen Sprachsicherheitsklassifikator, um anderen dabei zu helfen, ihre eigenen Sprachsicherheitssysteme zu verbessern. Wir arbeiten auch mit Dritten zusammen, um Wissen und bewährte Verfahren zu teilen, während sich die Branche weiterentwickelt. Wir pflegen enge Beziehungen zu einer Vielzahl von Organisationen, darunter Elternverbände, Organisationen für psychische Gesundheit, Regierungsbehörden und Strafverfolgungsbehörden. Sie liefern uns wertvolle Einblicke in die Bedenken, die Eltern, politische Entscheidungsträger und andere Gruppen hinsichtlich der Online-Sicherheit haben. Im Gegenzug können wir unser Wissen und die Technologie, die wir nutzen, um die Plattform sicher und anständig zu halten, teilen.

Wir haben eine Erfolgsbilanz darin, die Sicherheit der jüngsten und schutzbedürftigsten Personen auf unserer Plattform an erste Stelle zu setzen. Wir haben Programme etabliert, wie unser Trusted Flagger Program, um uns beim Ausbau unserer Reichweite zu unterstützen, während wir daran arbeiten, die Menschen auf unserer Plattform zu schützen. Wir arbeiten mit Politikern an wichtigen Initiativen zum Schutz der Kinder, Gesetzgebung und anderen Bemühungen zusammen. Zum Beispiel waren wir das erste und eines der wenigen Unternehmen, das den California Age-Appropriate Design Code Act unterstützte, weil wir glauben, dass es im besten Interesse junger Menschen liegt. Wenn wir glauben, dass etwas jungen Menschen helfen wird, möchten wir es allen zugänglich machen. In jüngster Zeit haben wir einen Unterstützungsbrief für den kalifornischen Gesetzesentwurf SB 933 unterzeichnet, der die staatlichen Gesetze ausdrücklich aktualisiert, um KI-generierte sexuelle Kindesmissbrauchsmaterialien zu verbieten.

Auf dem Weg zu einer sichereren Zukunft

Diese Arbeit ist nie abgeschlossen. Wir arbeiten bereits an der nächsten Generation von Sicherheitstools und -funktionen, während wir es gleichzeitig für jeden einfacher machen, auf Roblox zu erstellen. Wenn wir wachsen und neue Möglichkeiten zum Erstellen und Teilen bieten, werden wir weiterhin neue, bahnbrechende Lösungen entwickeln, um allen auf Roblox eine sicheren und anständigen Ort zu bieten.