Escalando segurança e civilidade na Roblox

by Matt Kaufman, Chief Safety Officer

Tecnologia

- A Roblox tem em seu design básico a proteção dos usuários mais jovens, agora estamos nos adaptando a uma audiência crescente de usuários mais velhos.

- Com texto, voz, visuais, modelos 3D e código-fonte, a Roblox está em uma posição única de suceder com soluções de IA multimodais.

- Melhoramos a segurança através da indústria onde possível, através de código aberto, colaborações com parceiros e suporte para legislação.

Segurança e civilidade tem sido a fundação da Roblox desde sua criação há duas décadas. No primeiro dia, nos comprometemos em construir funcionalidades de segurança e moderação no design de nossos produtos. Antes de lançarmos qualquer nova funcionalidade, já estamos pensando em como manter a comunidade segura contra potenciais problemas. Este processo de criar funcionalidades para segurança e civilidade no começo – incluindo testes preliminares para ver como uma nova funcionalidade pode ser usada de forma maliciosa – nos ajuda a inovar. Estamos avaliando continuamente as pesquisas e tecnologias mais recentes para manter nossas políticas, ferramentas e sistemas os mais precisos e eficientes possíveis.

Quando se trata de segurança, a Roblox tem uma posição singular. A maioria das plataformas começou como um local para adultos e agora estão trabalhando retroativamente para construir proteções para crianças e adolescentes. Nossa plataforma foi desenvolvida desde o começo para ser um espaço seguro para crianças criarem e aprenderem; e agora estamos nos adaptando para uma audiência mais velha que tem crescido rapidamente. Além disso, o volume de conteúdo que moderamos tem crescido exponencialmente, graças a novas funcionalidades de IA generativa e ferramentas que empoderam ainda mais pessoas a criar e se comunicar facilmente na Roblox. Estes desafios não são inesperados – nossa missão é conectar um bilhão de pessoas com otimismo e civilidade. Estamos sempre de olho no futuro para entender que novas políticas de segurança e ferramentas serão necessárias para nosso crescimento e adaptabilidade.

Muitas de nossas funcionalidades e ferramentas são baseadas em soluções inovativas de IA que são executadas junto com uma equipe de milhares de experts dedicados à segurança. A mistura estratégica de humanos experientes e automação inteligente é imperativa enquanto trabalhamos para escalar o volume de conteúdo que moderamos 24 horas por dia, 7 dias por semana. Também acreditamos em alimentar parcerias com organizações focadas em segurança online e, quando relevante, apoiamos legislações que acreditamos que beneficiarão a indústria como um todo.

Liderando com IA para escalar segurança

A escala de nossa plataforma demanda sistemas de IA que obedecem a parâmetros de tecnologia de ponta para precisão e eficiência, nos permitindo responder rapidamente ao crescimento de nossa comunidade, políticas, necessidades e aos novos desafios que surgem. Hoje, mais de 71 milhões de usuários ativos diários em 190 países se comunicam e compartilham conteúdo na Roblox. Todos os dias, bilhões de mensagens são enviadas em chats entre amizades. Nossa Loja do Criador tem milhões de itens à venda e criadores adicionam novos itens de avatar no Mercado todos os dias. E tudo isso tende a aumentar muito à medida que crescemos e ativamos novas maneiras de criar e se comunicar na Roblox.

Enquanto a indústria como um todo dá saltos em aprendizagem de máquina (ML), modelos grandes de linguagem (LLMs) e IA multimodal, nós investimos pesado em maneiras de alavancar essas novas soluções para tornar a Roblox ainda mais segura. Soluções de IA já nos ajudam a moderar chat de texto, comunicação imersiva com voz, imagens e modelos e malhas 3D. Também estamos usando muitas dessas tecnologias para tornar a criação na Roblox mais fácil e rápida para nossa comunidade.

Inovando com sistemas de IA multimodais

Por natureza, nossa plataforma combina texto, voz, imagens, modelos 3D e códigos-fonte. IA multimodal, onde sistemas são treinados em múltiplos tipos de dados agregados para produzir resultados mais precisos e sofisticados se comparado a um sistema unimodal, trazem uma oportunidade única para a Roblox. Sistemas multimodais são capazes de detectar combinações de tipos de conteúdo (como imagens e texto) que podem ser problemáticos de uma maneira em que elementos individuais não são. Para imaginar como isso pode funcionar, digamos que uma criança está usando um avatar que parece um porco – sem problemas, certo? Agora imagine que alguém manda uma mensagem que diz “Esse avatar é igual a você! ”. Essa mensagem viola nossas políticas contra bullying.

Um modelo treinado em modelos 3D aprovaria o avatar. E um modelo treinado somente em texto aprovaria o texto e ignoraria o conteúdo do avatar. Somente algo treinado em ambos texto e modelos 3D seria capaz de detectar rapidamente e alertar sobre o problema desse exemplo. Ainda estamos nos estágios iniciais dos modelos multimodais, mas vemos um futuro não muito distante onde nossos sistemas respondem a uma denúncia de abuso ao revisar uma experiência inteira. O modelo pode processar o código, os visuais, avatares e comunicações dentro da experiência como dados de entrada para determinar se é preciso fazer uma investigação e aplicar consequências.

Já fizemos avanços significativos usando técnicas multimodais, como nosso modelo que detecta violações de políticas em comunicações de voz rapidamente. Nossa intenção é compartilhar avanços como esse quando pudermos ver a oportunidade de aumentar a segurança e civilidade não só na Roblox, mas também na indústria. De fato, estamos compartilhando nosso primeiro modelo de código aberto com a indústria, um classificador de segurança de voz.

Moderando conteúdo em escala

Na Roblox, revisamos a maioria dos tipos de conteúdo para pegar violações críticas antes que elas apareçam na plataforma. Fazer isso sem causar atrasos notáveis para as pessoas que querem publicar conteúdo requer velocidade e precisão. Soluções de IA inovadoras nos ajudam a fazer decisões melhores em tempo real para nos ajudar a manter conteúdo problemático fora da Roblox. E se algo conseguir chegar na plataforma, temos sistemas prontos para identificar e remover tal conteúdo, incluindo nossos sistema robusto de denúncias dos usuários.

Temos acompanhado a precisão de nossas ferramentas de moderação automáticas superando os moderadores humanos quando se trata de tarefas simples e repetitivas. Ao automatizar os casos mais simples, deixamos nossos moderadores humanos livres para trabalhar no que eles fazem de melhor: as tarefas mais complexas que necessitam de pensamento crítico e investigação mais profunda. Quando se trata de segurança, no entanto, sabemos que a automação não substitui a revisão humana. Nossos moderadores humanos são valiosos em nosso contínuo monitoramento e teste de nossos modelos de linguagem para qualidade e consistência e para criar bancos de dados marcados de alta qualidade que mantém nossos sistemas atualizados. Eles nos ajudam a identificar novas gírias e abreviações nos 16 idiomas que suportamos e marcar os casos que aparecem com mais frequência, assim o sistema pode ser treinado para reconhecê-los.

Sabemos que até mesmo modelos de linguagem de alta qualidade podem cometer erros, então mantemos moderadores humanos em nossos processos de apelação. Nossos moderadores nos ajudam a agir de forma correta com o indivíduo que fez a apelação e a marcar a necessidade de mais treinamento nos tipos de casos em que foram cometidos erros. Com isso, nosso sistema cresce cada vez mais preciso com o tempo, essencialmente aprendendo com seus próprios erros.

Mais importante, humanos sempre estiveram envolvidos em quaisquer investigações críticas em casos de alto risco, como extremismo e risco para crianças. Para esses casos, temos uma equipe interna dedicada a trabalhar proativamente na identificação e remoção de maus atores e para investigar nossos casos mais difíceis nas áreas mais críticas. Essa equipe também faz parcerias com nossa equipe de produto, compartilhando informações do trabalho realizado para melhorar a segurança de nossa plataforma e produtos.

Moderando comunicação

Nosso filtro de texto foi treinado em linguagem específica da Roblox, incluindo gírias e abreviações. As 2,5 bilhões de mensagem de chat enviadas todos os dias na Roblox passam por esse filtro, que é adepto em detectar linguagem que viole nossas políticas. Esse filtro detecta violações em todas os idiomas que suportamos, o que é especialmente importante agora que lançamos traduções de chat por IA.

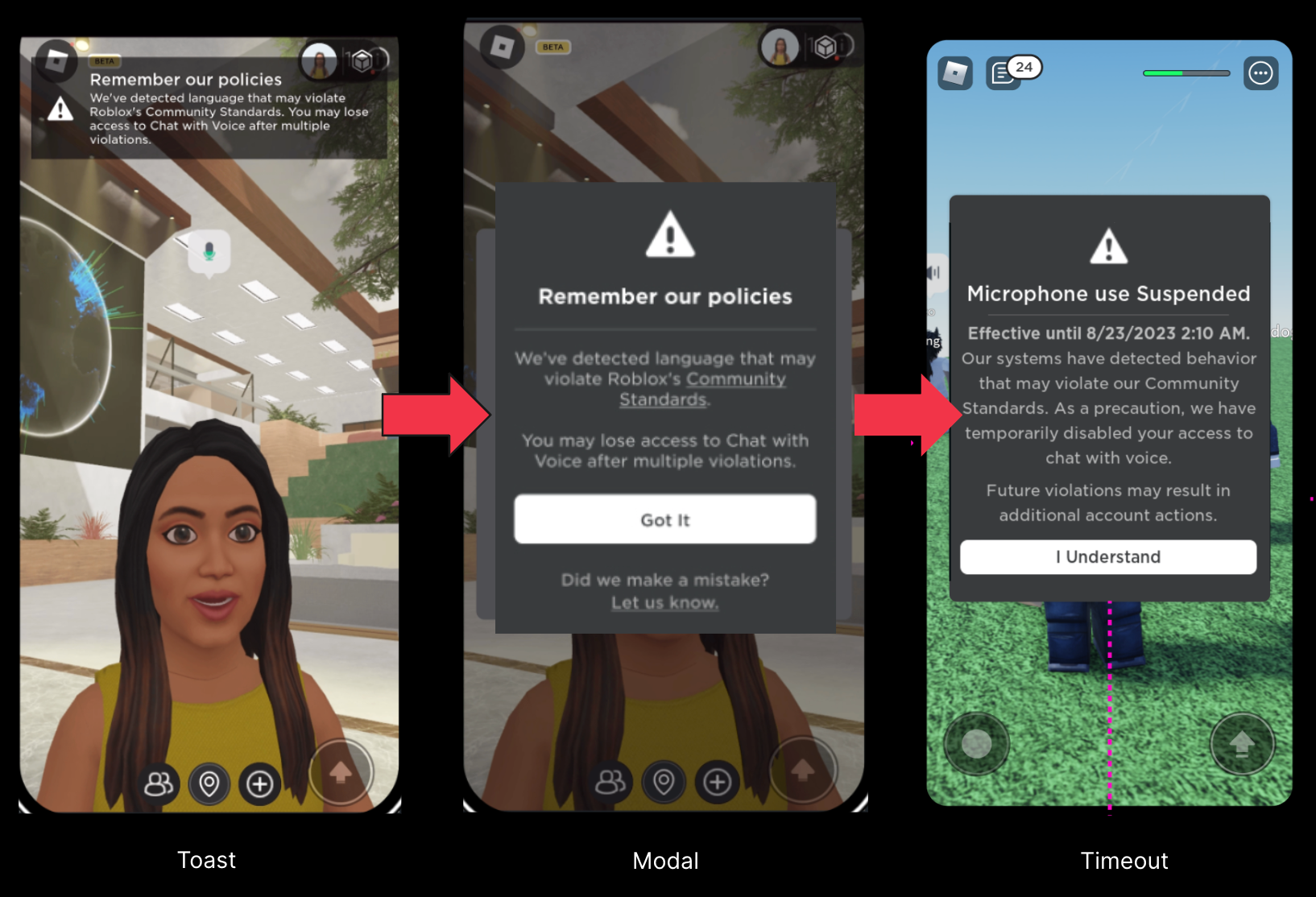

Anteriormente, compartilhamos como moderamos comunicação por voz em tempo real por um sistema interno de detecção de voz. A inovação aqui é a habilidade de ir diretamente de áudio ao vivo para a marcação por IA de uma violação de regra ou não em segundos. Ao começarmos a testar nosso sistema de moderação de voz, descobrimos que em muitos casos as pessoas estavam violando as regras sem más intenções simplesmente porque não estavam familiarizadas com nossas regras. Desenvolvemos um sistema de segurança em tempo real para ajudar a notificar as pessoas quando seus diálogos violassem nossas regras.

Essas notificações são apenas um aviso inicial, equivalente a pedir educadamente que uma pessoa controle sua linguagem em um parque onde haja crianças brincando. Em testes, essas intervenções foram bem-sucedidas em lembrar as pessoas a serem respeitosas e a direcioná-las a visitar nossas políticas para aprender mais. Quando comparado com dados de engajamento, os resultados de nossos testes são encorajadores ao indicar que essas ferramentas podem efetivamente excluir maus atores da plataforma e encorajar usuários com boa-fé a melhorar seu comportamento na Roblox. Desde que lançamos nossa segurança em tempo real para falantes de inglês em janeiro passado, vimos uma redução de 53 por cento em denúncias de abuso usuários por usuários ativos diários, quando relacionado à comunicação por voz.

Moderando criações

Para ativos visuais, incluindo avatares e acessórios de avatar, usamos visão de computador (CV – Computer Vision, em inglês). Uma técnica envolve tirar fotografias de um item de vários ângulos. O sistema então revisa essas fotos para determinar qual o próximo passo. Se nada parece estar errado, o item é aprovado. Se algo estiver violando as regras, o item é bloqueado e informamos ao criador o que achamos que é o problema. Se o sistema não tem certeza, o item é enviado a um moderador humano para um olhar mais rigoroso e uma decisão final.

Fazemos uma versão desse mesmo processo para avatares, acessórios, código-fonte e modelos 3D completos. Para modelos completos, damos um passo extra para observar todo o código e outros elementos que compõem o modelo. Se estivermos analisando um carro, o dividimos em componentes – o volante, assentos, pneus e todo o código incluso – para determinar se alguma coisa pode causar problemas. Se há um avatar que parece um cachorrinho, precisamos verificar se o nariz, orelhas e língua são problemáticos.

Precisamos também analisar de outra perspectiva. E se os componentes individuais não apresentam problema, mas o efeito como um todo viola nossas regras? Um bigode, uma jaqueta caqui e uma braçadeira vermelha, por exemplo, não apresentam problemas se estiverem separadas. Mas imagine tudo isso em um avatar com um símbolo parecido com uma cruz na braçadeira e um braço levantado fazendo a saudação nazista e o problema se torna bem claro.

É aí que nosso modelo interno difere dos modelos comerciais de CV. Os modelos comerciais geralmente são treinados em itens do mundo real. Eles podem reconhecer um carro ou um cachorro, mas não os componentes dessas coisas. Nossos modelos foram treinados e otimizados para analisar itens até o menor componente.

Colaborando com parceiros

Usamos as ferramentas disponíveis para manter todos na Roblox a salvo, mas também sentimos a necessidade de compartilhar o que aprendemos para além da Roblox. De fato, estamos compartilhando nosso primeiro modelo de código aberto, um classificador de segurança de voz, para ajudar outros a melhorar seus sistemas de segurança de voz. Também fizemos parcerias com terceiros para compartilhar conhecimento e boas práticas à medida que a indústria evolui. Construímos e mantemos relacionamentos com uma variedade de organizações, incluindo grupos de ativismo de pais, organizações voltadas para saúde mental, agências do governo e órgão da lei. Eles nos dão informações valiosas sobre as preocupações de pais, legisladores e outros grupos sobre segurança online. Em troca, podemos compartilhar o que aprendemos e a tecnologia que usamos para manter a plataforma civil e segura.

Temos um registro de colocar a segurança dos mais jovens e mais vulneráveis em primeiro lugar na plataforma. Estabelecemos programas como o Marcador de Confiabilidade para nos ajudar a escalar nosso alcance enquanto trabalhamos para proteger as pessoas em nossa plataforma. Colaboramos com legisladores em iniciativas chave para segurança infantil, leis e outros esforços. Por exemplo, fomos os primeiros e uma das poucas empresas a apoiar a Lei de Design de Código Apropriado para a Idade do Estado da Califórnia, pois acreditamos que é o melhor para as crianças e jovens. Quando acreditamos que algo pode beneficiar o público mais jovem, queremos propagar para todos. Recentemente, assinamos uma carta de apoio à Proposta de Lei SB 933 da Califórnia, que atualiza leis estaduais para expressamente proibir materiais gerados por IA que contenham abuso sexual infantil.

Rumo a um futuro mais seguro

Este trabalho nunca vai terminar. Já estamos trabalhando na próxima geração de ferramentas e funcionalidades de segurança, mesmo facilitando a criação na Roblox. Enquanto crescemos e criamos maneiras de criar e compartilhar, continuaremos a desenvolver soluções novas e impactantes para manter todos seguros e civis na Roblox – e além.